日前,北京大学计算机系、网络所的杨智副研究员课题组在深度学习编译优化和资源管理方面的工作双双取得重要突破,相关成果以学术论文Rammer: Enabling Holistic Deep Learning Compiler Optimizations with rTasks和HiveD: Sharing a GPU Cluster for Deep Learning with Guarantees的形式即将呈现在第14届“USENIX操作系统设计与实现研讨会”(OSDI: USENIX Symposium on Operating Systems Design and Implementation)上。这是北京大学首次以第一单位在该会议上发表论文。

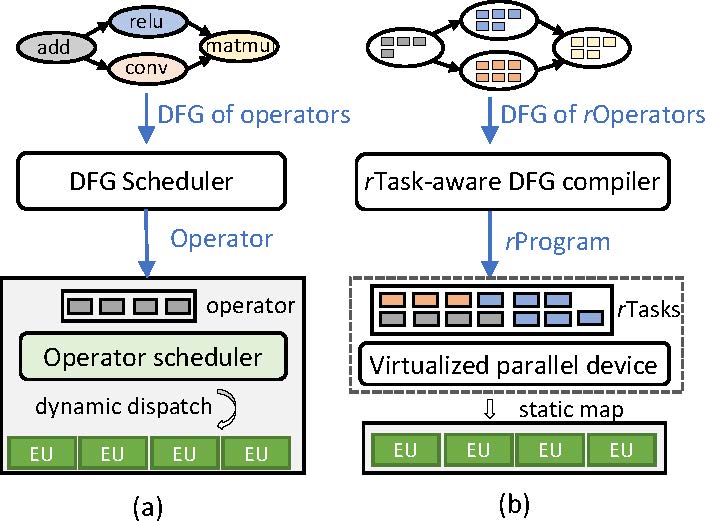

在前一篇论文中,杨智及其指导的博士研究生马林霄(第一作者)与微软的研发人员设计了一种新的深度学习编译系统Rammer,如图1所示,该系统改变了目前深度学习框架的系统结构,通过细粒度的计算抽象和编译,实现高效的深度学习计算加速,比目前流行的TVM、XLA深度学习编译器高达20倍以上的加速。

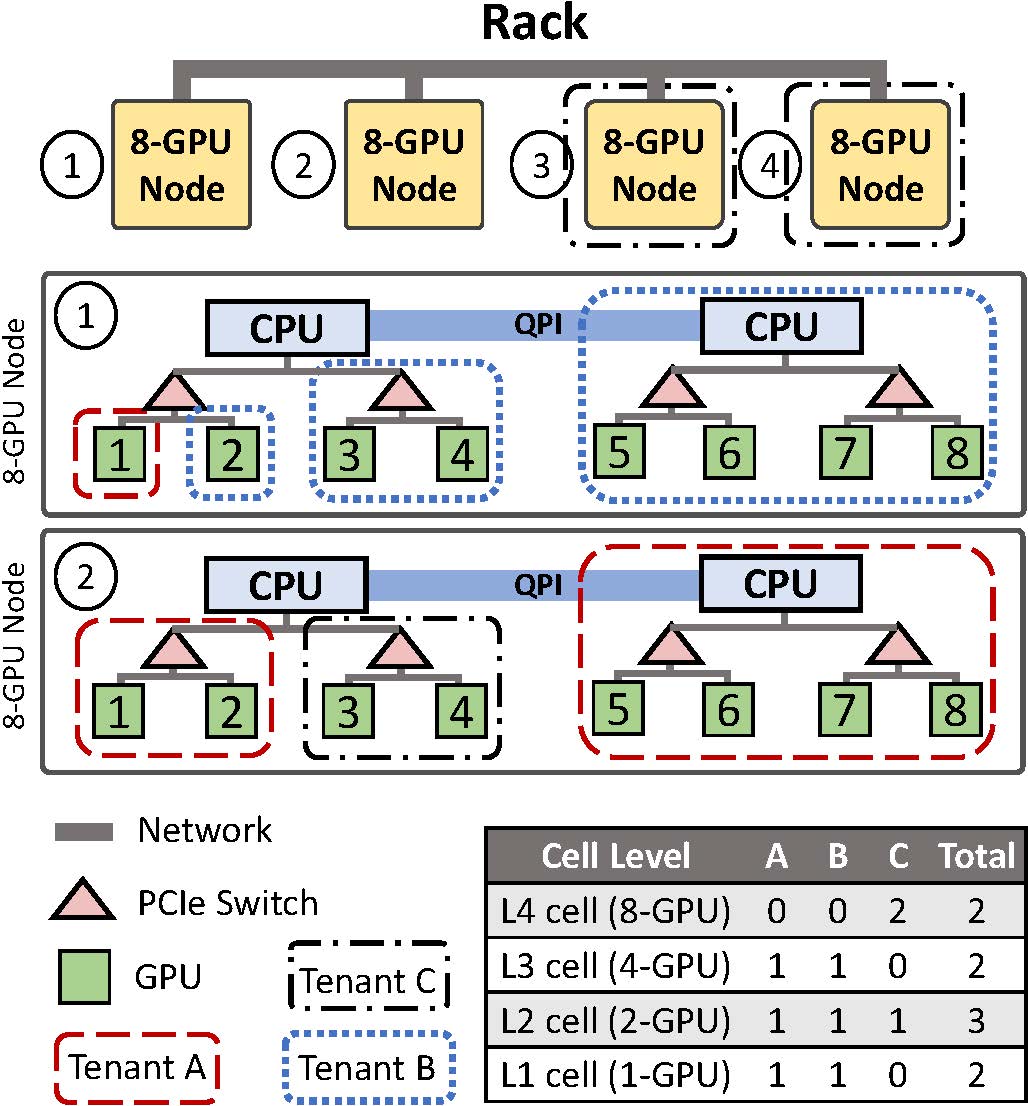

图1 现有DNN系统和Rammer系统结构对比 图2 GPU集群资源管理抽象

在后一篇论文中,杨智及其指导的博士研究生赵汉宇(第一作者)与微软的研发人员设计了一种新的深度学习集群资源管理系统HiveD,它考虑了深度学习模型训练效率和GPU拓扑间的关系,首次提出多租户共享安全性的概念,并设计相应的资源抽象GPU cells和分配算法,如图2所示,能够在理论上保证共享安全性。

以上论文的相关研究工作得到了国家自然科学基金的资助,以及北京大学大数据科学研究中心的支持。

背景链接:OSDI是计算机系统软件领域的最顶级会议,两年一届,被誉为操作系统原理领域的奥斯卡,拥有极高的学术地位。国内大学教师2016年在该会议首次发表论文,目前总数不超过10篇。第14届OSDI将于2020年11月4日至6日在加拿大的班夫(Banff)召开。此次会议投稿398篇,共录用论文70篇,录用率不足18%。